Imagínese a un abogado que presenta con confianza un escrito ante el tribunal lleno de detallados precedentes jurídicos, citas solemnes, nombres de jueces autorizados. Entonces descubre que todo es falso: los casos no existen, los jueces nunca pronunciaron esas palabras. ¿El culpable? ChatGPT, que confabuló una realidad paralela. Este episodio, que ocurrió realmente en 2023, no es una excepción. Es un síntoma de un problema más profundo: ¿por qué la IA inventa la información? Y, sobre todo, ¿cómo definir estos errores sin caer en metáforas equívocas o estigmatizantes, como «alucinación»?

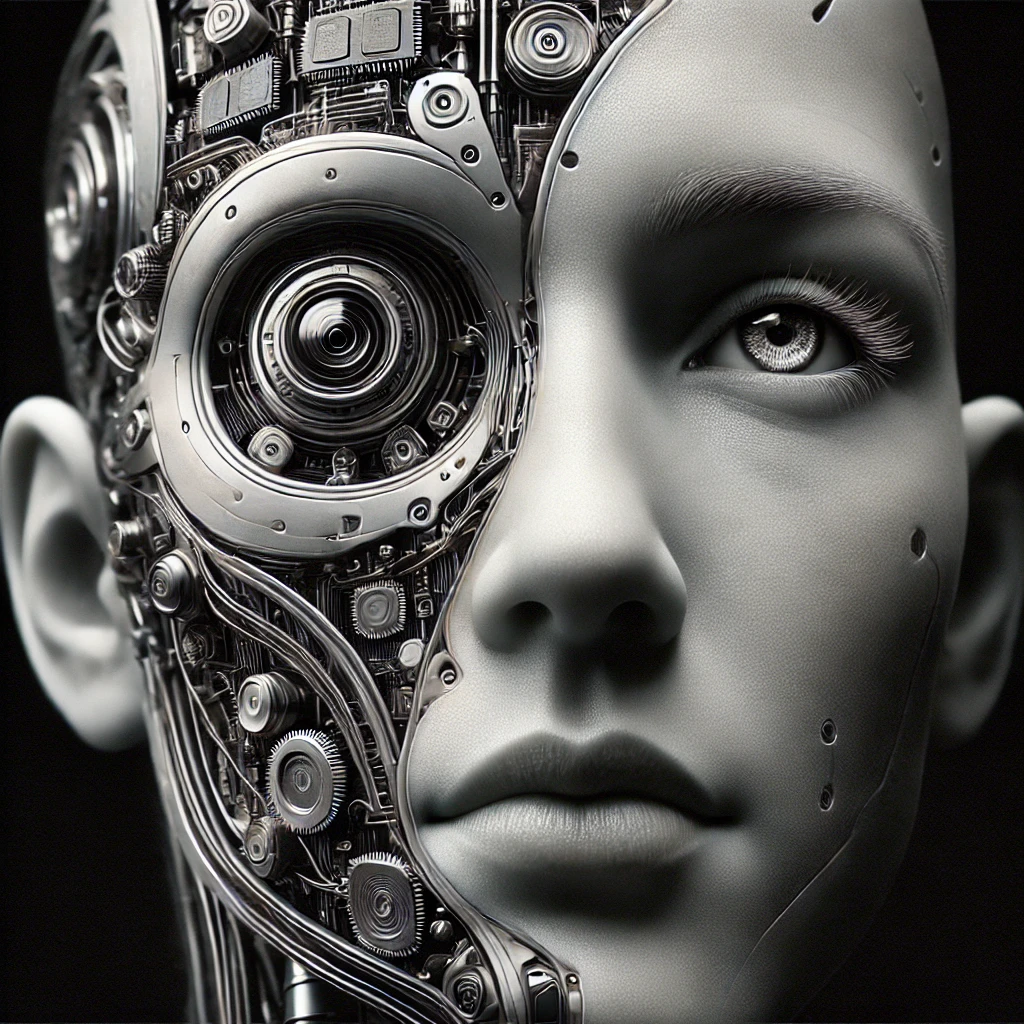

El concepto de alucinación en los modelos de Inteligencia Artificial ha ocupado un lugar central en la discusión sobre las limitaciones epistémicas y estructurales de tales sistemas. El uso de esta terminología para describir el tratamiento de información que no corresponde a un dato referencial plantea interrogantes no sólo desde un punto de vista técnico, sino también conceptual. Se trata de saber si el término es una metáfora adecuada o si, por el contrario, se necesita un vocabulario más preciso para describir el fenómeno.

¿Alucinaciones creativas o errores sistémicos?

Todo empezó con un malentendido. En el año 2000, los investigadores del campo de la visión por ordenador utilizaban el término «alucinación » para describir un proceso útil: algoritmos que reconstruían los píxeles que faltaban en las imágenes, «imaginando» detalles plausibles. Era una habilidad útil, no un defecto. Pero con la llegada de grandes modelos lingüísticos como GPT en los últimos años, el significado ha cambiado rápidamente.

Hoy en día, «alucinación» evoca errores embarazosos: traducciones que distorsionan el significado original, artículos académicos con referencias inexistentes, chatbots que citan estudios que nunca se publicaron.

El problema, como señalan Østergaard y Nielbo en un reciente artículo publicado en Schizophrenia Bulletin(2023), es que la comparación con las alucinaciones humanas es científicamente inexacta y socialmente peligrosa. Las alucinaciones humanas -escuchar voces o ver objetos inexistentes- son percepciones subjetivas vinculadas a trastornos neurológicos o psiquiátricos. La IA, en cambio, no percibe nada. Sus errores se derivan de cálculos estadísticos: patrones aprendidos a partir de enormes conjuntos de datos, a menudo contaminados por sesgos o información obsoleta. Llamarlas «alucinaciones» no sólo trivializa complejas condiciones médicas, sino que oscurece la verdadera naturaleza del problema: la IA no es un paciente psiquiátrico, es un sistema que optimiza la probabilidad lingüística. Y llamar alucinaciones a estas optimizaciones erróneas, que en esencia son aproximaciones estadísticas tan grandes que a veces están totalmente fuera de lugar, no sólo oscurece la verdadera naturaleza del problema, sino que también lleva a la gente a asociar estas herramientas con el hecho de que son similares a las mentes pensantes.

¿Existe un término mejor? El periodista de Ars Technica Benj Edwards propone «confabulación», tomándolo prestado de la neuropsiquiatría. En el síndrome de Korsakov, un trastorno relacionado con la carencia de vitamina B1, los pacientes rellenan lagunas de memoria con narraciones intrincadas y convincentes. Una persona mayor podría describir un viaje a China que nunca tuvo lugar, insertando detalles realistas (nombres de ciudades, trenes, colegas): no estaría «mintiendo» en sentido estricto: su cerebro estaría buscando la coherencia, aun a costa de inventar.

En realidad, la IA hace algo parecido. Cuando ChatGPT genera una cita falsa, lo hace porque está combinando fragmentos de texto aprendidos durante el entrenamiento -nombres de tribunales, fórmulas jurídicas, estructuras sintácticas- en una narración fluida pero ficticia. Al igual que el paciente de Korsakov, no tiene intención de engañar: simplemente sigue el imperativo estadístico de completar la indicación de la forma más plausible. Y, como en la clínica, el error sólo aflora más tarde: cuando el abogado descubre los casos inexistentes, o el estudiante se da cuenta de que la bibliografía de su trabajo es inventada.

En resumen: para mentir hay que saber que se está haciendo.

¡Mentira!

Pero si «confabulación» suena demasiado técnico, hay quien nos invita a llamar a las cosas por su nombre: gilipolleces. El filósofo Harry Frankfurt, en su ensayo On Bullshit (2005), distingue la mentira -una afirmación intencionadamente falsa- de la gilipollez, producida por quienes son indiferentes a la verdad. Un político que promete soluciones irrealizables para ganar consenso, o un estudiante que va de farol en un examen, no mienten necesariamente: dicen cosas que suenan bien, independientemente de que se correspondan o no con los hechos.

Según Hicks et al. (2024), ChatGPT es un ejemplo perfecto de generador de mentiras: genera declaraciones suaves y persuasivas, pero a menudo completamente indiferentes a la verdad. La razón reside en el diseño de los propios modelos lingüísticos: están optimizados para producir textos similares a los humanos, no para garantizar la precisión.

Aumentando la «temperatura» del modelo -parámetro que controla la «creatividad» (es decir, la amplitud en la elección de las variables que deben tener en cuenta los transformadores)- se obtienen respuestas más originales, pero también más propensas a las invenciones imaginativas. ¿Cuál es el resultado? Un sistema que, como diría Frankfurt, «socava la distinción entre verdadero y falso», normalizando la idea de que la verdad es negociable. Desde este punto de vista, de hecho, la IA no miente en el sentido estricto de la palabra (de hecho, ni siquiera sabe cuál es la diferencia epistemológica entre verdadero y falso), sino que genera salidas basadas únicamente en la coherencia sintáctica y la probabilidad estadística, sin una comprobación semántica de la adherencia de los contenidos a la realidad empírica.

Los ejemplos abundan. En 2023, un estudio publicado en Psychiatry Research reveló que ChatGPT inventa el 30% de las citas bibliográficas en psiquiatría, insertando autores y títulos de artículos inexistentes. Ese mismo año, es el caso citado al principio de este artículo, un abogado neoyorquino fue sancionado por haber presentado ante un tribunal un escrito lleno de precedentes judiciales generados por ChatGPT: falsificaciones tan convincentes que ni siquiera el juez las reconoció inicialmente como tales.

Detrás de estos episodios hay una dinámica técnica precisa. Los modelos lingüísticos no tienen acceso al mundo real: operan en un universo de palabras y estadísticas. Si en los datos de entrenamiento aparecen frases como «Einstein dijo…» o «el Tribunal Supremo dictaminó…» , el modelo aprende a utilizar esos nombres en contextos plausibles, sin comprobar su autenticidad. Es un problema de base: para la IA, «París es la capital de Francia» y «París es una manzana en Marte» son meras secuencias de palabras, evaluadas según su frecuencia en los textos, no según su veracidad.

La responsabilidad en el lenguaje es necesaria para una IA responsable

En un momento en que la atención prestada a la IA es máxima por parte de la prensa, los responsables políticos y los políticos, es crucial evitar generar malentendidos utilizando términos (¿deliberadamente?) engañosos.

El uso de una terminología más precisa es esencial no sólo para una correcta comprensión científica del fenómeno, sino también para el desarrollo de estrategias que mitiguen las imprecisiones producidas por los modelos de inteligencia artificial. Definir un error de inferencia como una alucinación no es sólo una forma fácil de transmitir un concepto. Corre el riesgo de ser un sistema que cambia insidiosamente la naturaleza misma del concepto en su esencia, acercándolo a lo que se pretende transmitir.

Es difícil convencer al público de que es necesario enseñar ética a una calculadora grande y compleja. Es mucho más fácil hacerlo si conviertes esa calculadora en una mente tan sensible que incluso alucina.

¿No queremos hablar del error de inferencia porque es demasiado complejo? La confabulación, con toda su ambigüedad, es una metáfora poderosa: nos recuerda que la IA no está enferma ni es maliciosa, sino un sistema que busca la coherencia estadística a toda costa, porque es la única verdad en un sistema que -estructuralmente- es incapaz de entender el concepto de verdad.

l riesgo más insidioso es acostumbrarse a las patrañas. Si normalizamos la idea de que la IA puede «cometer errores creativos», corremos el riesgo de erosionar la confianza en el propio conocimiento. El reto para los expertos no es sólo técnico -mejorar los algoritmos-, sino cultural: redefinir la forma en que hablamos de estos errores, eligiendo palabras que respeten tanto la ciencia como la dignidad humana. Porque, al fin y al cabo, las metáforas que utilizamos determinan nuestra forma de entender -y gobernar- la tecnología.